AIxiv专栏是本站发布学术、技术内容的栏目。过去数年,本站AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com。

-

论文链接:https://arxiv.org/abs/2403.12494 -

代码链接:https://github.com/YangSun22/TC-MoA -

论文题目:Task-Customized Mixture of Adapters for General Image Fusion

-

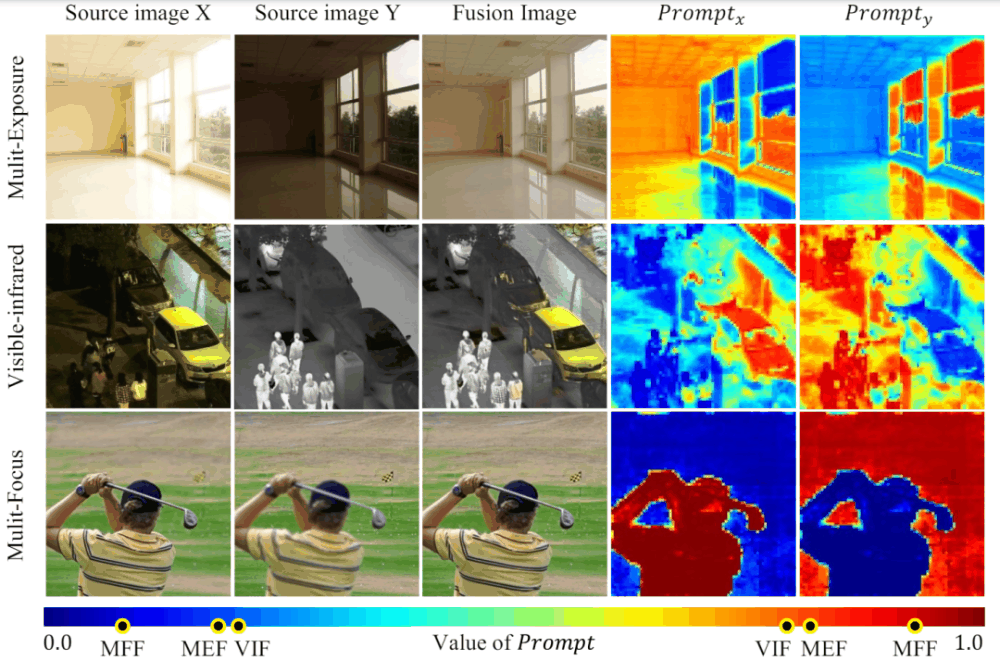

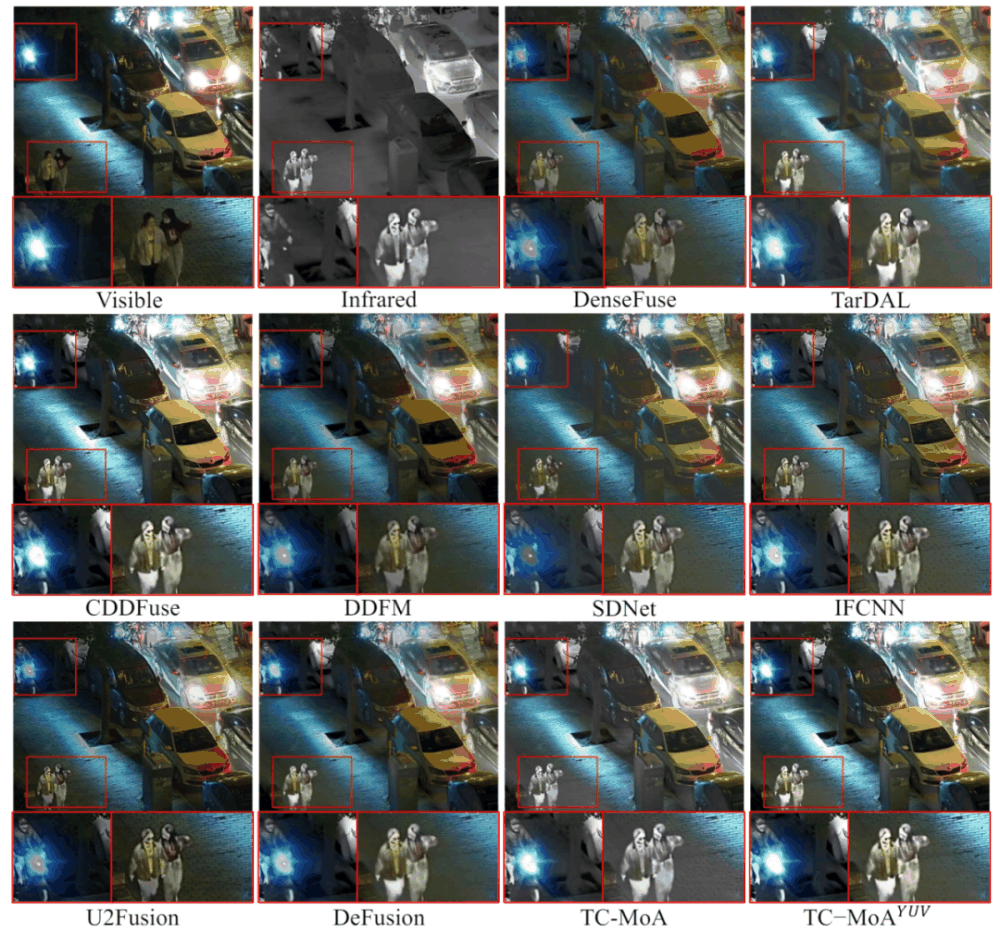

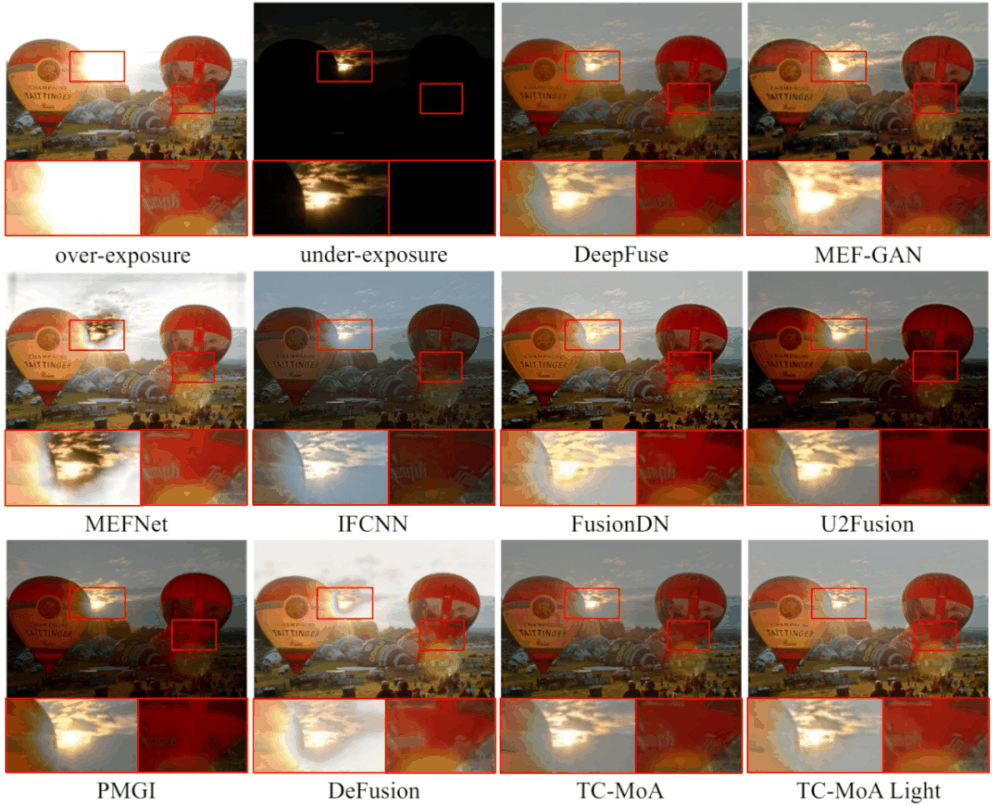

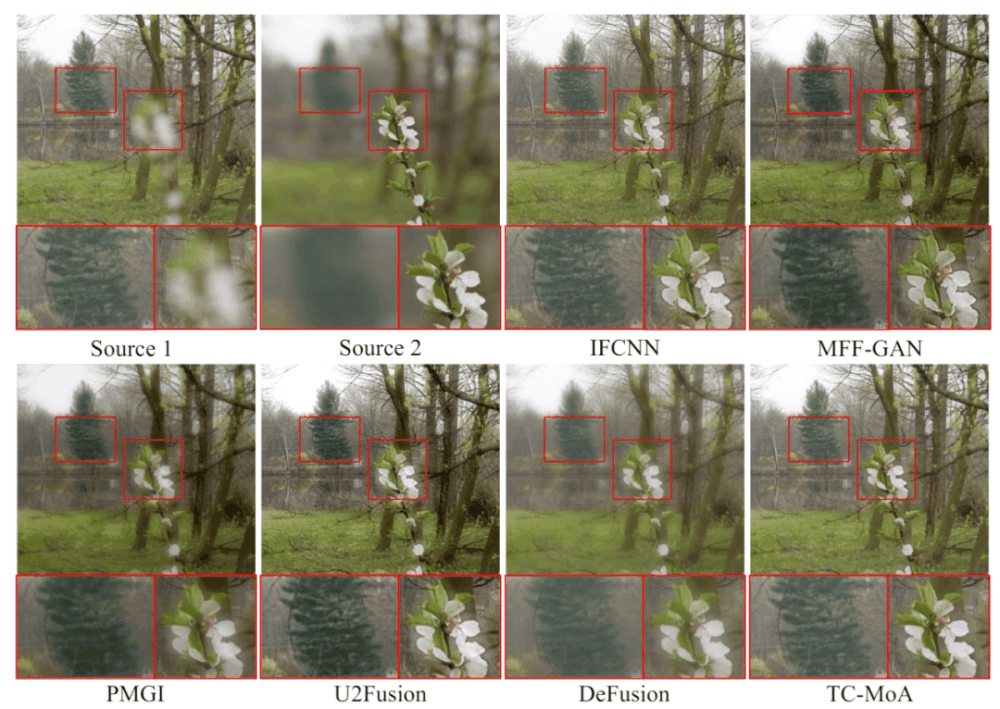

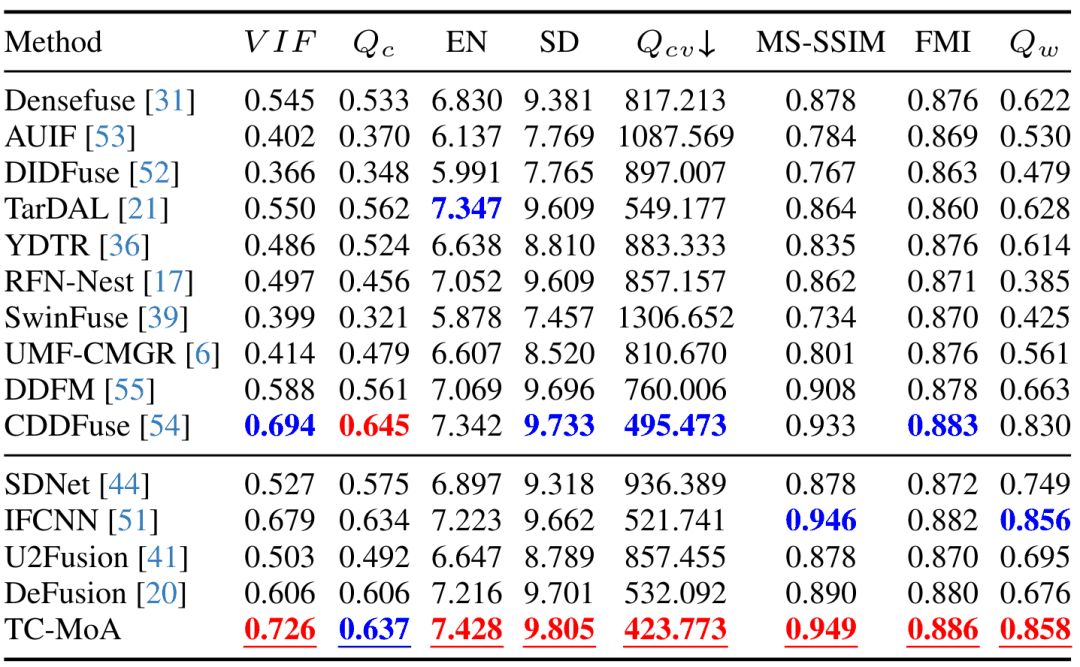

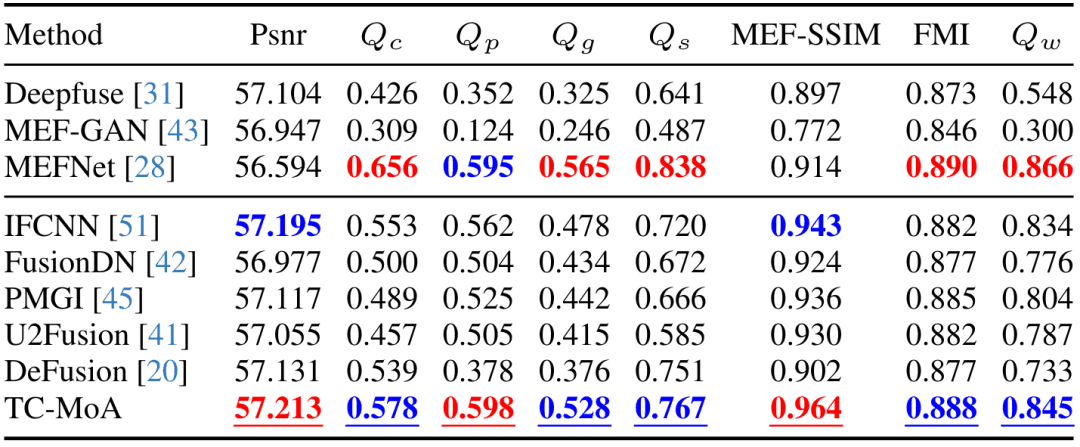

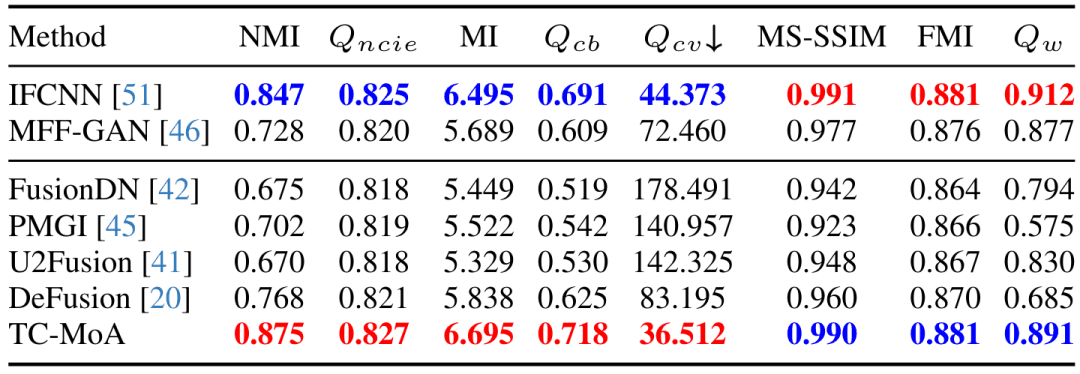

我们提出了一个统一的通用图像融合模型,提供了一种新的任务定制混合适配器(TC-MoA)用于自适应多源图像融合(受益于动态聚合各自模式的有效信息)。 -

我们为适配器提出了一种互信息正则化方法,这使得我们的模型能够更准确地识别不同源图像的主导强度。 -

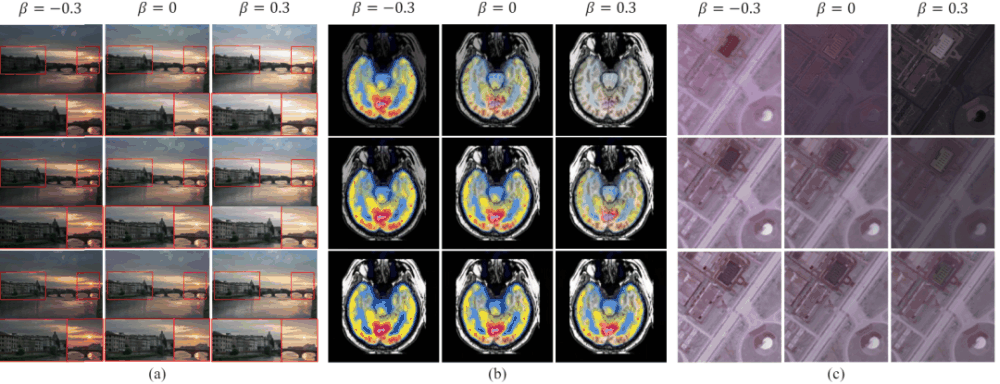

据我们所知,我们首次提出了一种基于 MoE 的灵活适配器。通过只添加 2.8% 的可学习参数,我们的模型可以处理许多融合任务。大量的实验证明了我们的竞争方法的优势,同时显示了显著的可控性和泛化性。

,网络整合来自不同源的互补信息,获得融合图像

,网络整合来自不同源的互补信息,获得融合图像 。我们将源图像输入 ViT 网络,并通过 patch 编码层获得源图像的 Token。ViT 由一个用于特征提取的编码器和一个用于图像重建的解码器组成,这两者都是由 Transformer 块组成的。

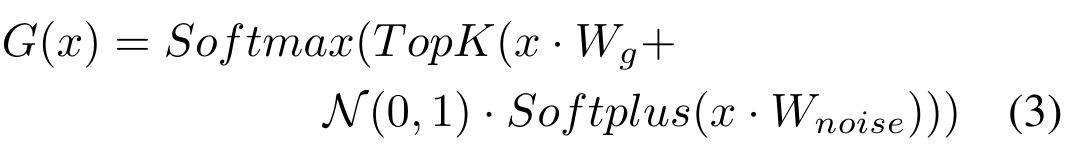

。我们将源图像输入 ViT 网络,并通过 patch 编码层获得源图像的 Token。ViT 由一个用于特征提取的编码器和一个用于图像重建的解码器组成,这两者都是由 Transformer 块组成的。 个 Transformer 块插入一个 TC-MoA。网络通过这些 TC-MoA 逐步调制融合的结果。每个 TC-MoA 由一个特定于任务的路由器银行

个 Transformer 块插入一个 TC-MoA。网络通过这些 TC-MoA 逐步调制融合的结果。每个 TC-MoA 由一个特定于任务的路由器银行 ,一个任务共享适配器银行

,一个任务共享适配器银行 和一个提示融合层F组成。TC-MoA 包括两个主要阶段:提示生成和提示驱动的融合。为了便于表达,我们以 VIF 为例,假设输入来自 VIF 数据集,并使用G来表示

和一个提示融合层F组成。TC-MoA 包括两个主要阶段:提示生成和提示驱动的融合。为了便于表达,我们以 VIF 为例,假设输入来自 VIF 数据集,并使用G来表示 。

。

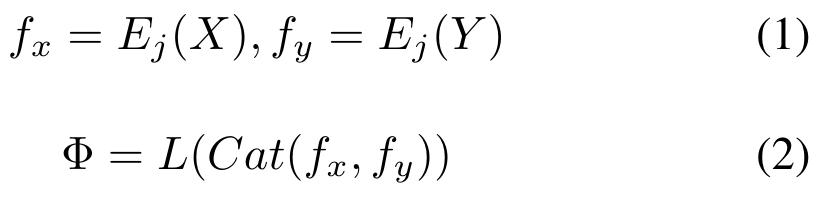

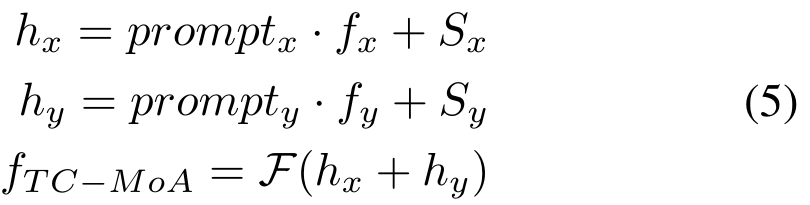

,并提取提示生成特征定义为

,并提取提示生成特征定义为 。我们将

。我们将 作为多源 Token 对的特征表示拼接起来。这允许来自不同来源的 Token 在后续的网络中交换信息。然而,直接计算高维的拼接特征会带来大量不必要的参数。因此,我们使用

作为多源 Token 对的特征表示拼接起来。这允许来自不同来源的 Token 在后续的网络中交换信息。然而,直接计算高维的拼接特征会带来大量不必要的参数。因此,我们使用 进行特征降维,得到处理后的多源特征

进行特征降维,得到处理后的多源特征 ,如下:

,如下:

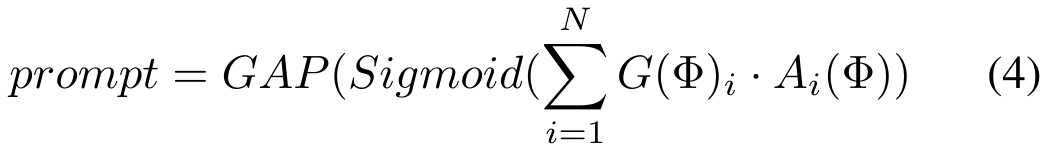

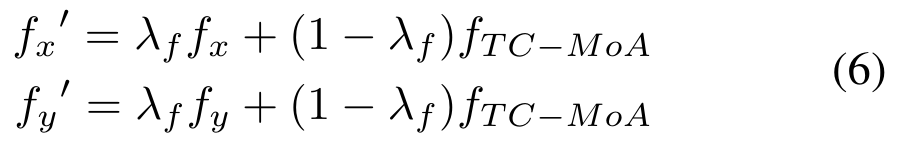

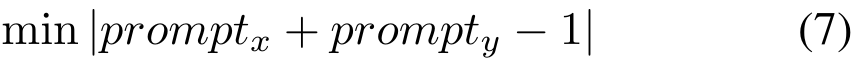

,然后经过融合层 F 获得融合特征,过程如下:

,然后经过融合层 F 获得融合特征,过程如下:

是一个超参数):

是一个超参数):

以上就是CVPR 2024 | 基于MoE的通用图像融合模型,添加2.8%参数完成多项任务的详细内容,更多请关注叮当号网其它相关文章!

文章来自互联网,只做分享使用。发布者:叮当,转转请注明出处:https://www.dingdanghao.com/article/397299.html